Информационните процеси търсене, обработка, съхранение и предаване

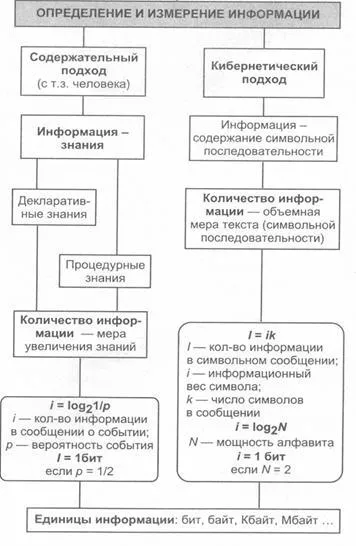

Основните подходи за дефинирането на понятието "информация". Данните от измерванията, теория на информацията и техника. Изчисляване на количеството информация.

Терминът "информация" идва от латинската = Информация. което означава, обяснение, представяне на осведомеността. От гледна точка на материалистическата философия на информация е отражение на реалния свят, чрез използване на информацията (съобщения). Съобщение - е форма на представяне на информация под формата на глас, текст, изображения, цифров, данни, графики, таблици и т.н. В общи линии, информацията - е общ научен термин, който включва обмен на информация между хората, обмен на сигнали между живата и неживата природа, хора и устройства.

Концепцията на информация е един от най-основните в съвременната наука. Въпреки това, формалната дефиниция на това понятие е трудно (както понятието "точка" или "директен" в геометрията). В ежедневието разбирателство с "информацията", термин, обикновено асоциативен-ating част от информацията, данни, знания и т.н.

Съобщение от източника до местоназначението винаги се изпраща чрез всяко едно средство, което в този случай "комуникационен канал" (звук - въздух, текст - лист и други подобни).

Човешката природа на субективното възприемане на информация през някои по-бор неговите свойства: значението, надеждност, навременност, достъпност и т.н. В този смисъл едно и също послание предава от източника до местоназначението може да предава информация в различни степени.

Представители на атрибутивна концепцията (. Abdeev, Bazhenov, Petrushenka, Урсула и други) смятат, че информация - атрибут на материята, т.е. собственост на всяка една система за обективна реалност.

(. Tsidrya Афанасиев, Шрьодер и други) Представители на антропоцентрична концепция смятат, че информацията не може да се счита човека и извън компанията; то се счита за момент на сигнал, системата получава от външния свят.

Измерване на информация (по-различен подход)

Най-често се използват следните два метода за измерване на информация: обемен и вероятностно.

Обемна подход. В двоична бройна система подписва 0 и 1 ще се нарича малко (от английски втория израз нули и единици, най - двоични цифри). Дайте предимство на двоична система, тъй като техническото съоръжение, най-простите за изпълнение на две противоположни физическо състояние: магнитизирана / магнитизирана не за включване / изключване .. зареден / не зарежда и др.

Обемът на информацията, съхранявана двоични символи в паметта на компютъра или на външен носител, се изчислява само на броя необходими за запис на двоични символи. В тази невъзможност, но noninteger брой битове.

За улеснение въведе и по-голям от информацията, коли-операция на малко устройство. По този начин, двоична дума от осем знака, включваща един байт на информация, 1024 байт форма килобайта (КБ), 1024 килобайти - мегабайта (МБ), както и 1024 мегабайта - гигабайта (GB).

Ентропия (вероятност) подход. Този подход е приет в теорията на информацията и кодиране. Този метод на измерване се основава на следния модел: Получателят на съобщението има ясна идея вероятността от възникване на определени събития. Тези изявления са ненадеждни и изразява вероятността, с която го очаква това или онова събитие. Обща мярка несигурност, наречена ентропия. Ентропията се характеризира с математическа зависимост агрегат вероятност за тези събития.

Размерът на информация в съобщението се определя от това колко намалява мярката след получаване на съобщение: по-голяма е ентропията на системата, толкова по-голяма степен на несигурност. Входящото съобщение е напълно или частично премахва този двусмислие, следователно, количеството на информация може да се измерва чрез степента, до намаляване на ентропията на системата след получаване на съобщението. Като мярка за количеството на информацията е получена на същата ентропията, но с обратен знак.

Вземем примера за изчисляване на размера на информация, докладвана появата на един от N еднакво вероятни събития. Означаваме цифров количество, което измерва несигурност (ентропията) чрез Н. стойности на N и Н са свързани функционална връзка: Н = F (N). Тази функция е очевидно увеличаване и някои не-отрицателни за всички стойности на 1, 2, ..., N.

Ще означаваме с несигурност H1, съществуващ преди настъпване на събитието. Чрез H2 - несигурност след събитието. След това, за I - количеството информация за резултата от опита - ние се разликата между несигурност преди и след опита: I = H1 - H2.

В случая, когато се получава специфичен резултат, който бе отстранен несигурност (като Н2 = 0). По този начин сумата на получената информация съвпада с оригиналния ентропията. Несигурността, обвити в експеримента съвпада с информация за резултатите от този експеримент.

Определяне Н = е функция (М). Ние променя N (броят на възможните резултати) и M (брой експерименти). Общият брой на резултатите е равно на X = N М. Всеки резултат - вектор, на дължина М., състояща се от символи 1, 2, ..., N.

Ситуацията с M провеждат експерименти може да се разглежда като сложна система, състояща се от взаимно независими подсистеми - единични експерименти. Ентропията на такава система е М пъти по-дълго от ентропията на система (така наречените "принципа на адитивност на ентропията») е (N М) = М е (N).

Логаритъм на лявата и дясната страна на уравнението X = N M. получаване на:

Заместването на стойността на М в уравнение е (N M) = М е (N), ние получаваме:

Обозначаваща положителна константа. ние получаваме формула :.

Получената формула се нарича формула Хартли.

Важна с въвеждането на количество е въпросът за това какво да се вземе за мерна единица. Очевидно, Н е равно на едно, когато N = 2. С други думи, като устройството на получената информация, свързана с извършването на експеримента, състояща се от получаване на една от двете еднакво iskho редове (например, монета хвърляне). Такава единица количество информация се нарича малко.

Всички резултати N обсъдени по-горе са еднакво вероятни и опит в тази можем да предположим, че "акция" на всеки изход, има една N-ти на общата неопределеност на опит :. вероятност Pi аз тият изход; Това се равнява ясно 1 / N. По този начин:

Същата (крайна) формула се приема като мярка на ентропията в случай, вероятността от различни опит еднакво вероятни резултати (т.е. стойността на Pi може да варира). Тази формула се нарича формула Шанън.

Забележка: за данни Vd обем съобщено тук се отнася до броя на символите в съобщението (т.е., какво се разбира под малко по подход обем).

Пример 1. Определяне на количеството на информацията, свързана с появата на всеки знак в съобщението на руски. Предполагаме, че п = 34 (33 символи и интервали). След това:

Пример 2. Въпреки това, по думите на българския език (и други езици) на различните букви се показват по различен често. Ако използваме таблицата на вероятностите се използват различни честотни български азбука, а след това от Шанън може да се изчисли стойността на H. Този резултат ще бъде малко по-малко от изчислена по-горе (4.72), тъй като стойността, изчислена по формулата AN Хартли, е максималното количество информация, което би могло да падне на един знак.

Забележка: За едно и също послание до различни стойности на количеството информация може да бъде получена с помощта на различни подходи (но приблизително равен). Количеството на информация, получена от формули Shannon-Hartley не може да бъде повече от количеството на информацията, получена обемен метод.

Пример 3. Да разгледаме азбука, съставена от два символа 0 и 1. Ако приемем, че ками със стойности 0 и 1 в двоичен азбука свързани идентичен тяхната поява вероятност (P0 = Р1 = 0.5), количеството на информация за характера на двоично-кодира Ваня е равно на N = log2 2 = 1 бит. По този начин сумата на информация (в битове), затворен в двоична дума равен на броя на нули и единици в нея.

Други (по-малко известни) информационни методи за измерване

Алгоритмичната подход. Всеки пост може да се дължи на количествен характеристика на отражателната програма сложност (размер), което позволява да се произвеждат. Тъй като има много различни компютри и програмни езици, т.е. различни начини на писане на алгоритъма, а след сигурност са дадени някои специфични машина, като машина на Тюринг. След това, както се изисква количествена характеристика на съобщенията могат да се минимален брой вътрешни държавната машина, за да играе на това съобщение.

Семантичната подход. За измерване на семантична информационното съдържание, т.е. неговото количество в семантично ниво, най-високото отличие на мярката за синонимен речник. която свързва семантиката кал свойства на информацията от възможността потребителят да получава входящи съобщения. Той използва понятието "потребител синонимен речник".

Синонимен речник - набор от информация, достъпна за благоволението на Vatel или система.

Максималният брой на семантична информация покупки Ic потребителите при координирането на семантична неговото съдържание S със своя речник SP. когато входящата информация, разбираем за потребителя и носи не по-рано известен (липсва в неговия речник) информация.

При оценяването на семантично (съдържателен) аспект на информацията, необходима да се стреми да хармонизира и количества S Sp.

Относителната мярка за количеството на семантична информация може да бъде смисленост коефициент С, което се определя като съотношението на семантична информация за обема си :.

Прагматичен подход. Тази мярка определя полезността на информация (стойност), за да се постигне целта от страна на потребителя. Тази мярка е също относителна стойност, поради ексцентричности tyami използване на тази информация в една или друга система. Стойността на информация, полезна за измерване в същите единици (или близо до него), в която измеримо ryaetsya-целевата функция.