Как да създадете роботи TXT файл за WordPress, отбелязва уебмастър

В тази статия ще говорим за оптимизиране на вашия блог чрез файла robots.txt, това точене за търсачките и защо е необходимо да се направи това.

Как да създадете Роботи TXT за WordPress?

Не е тайна, че повече от 70-80% от трафика на сайта ни идва от търсене или търсачки (PS).

Много от вас, които имат свои собствени лични блогове или сайтове пишат за тях интересни статии. като по този начин се опитва да помогне на хората да решават своите непосредствени проблеми в определена област.

Някои блогъри твърдят, че те не трябва да оптимизирате сайта си ( "... защо това Роботи TXT? ...»), както и факта, че тя ще стигне до голям брой хора, тъй като те имат уникална статия ...

Как да създадете Роботи TXT

Роботи ще инсталирате файла на вашия WordPress блог, и по този начин да се увеличи потока на посетителите на СС на техните ресурси!

Фактът, че на директориите Wordpres ите система е много скриптове за поддръжка, страници, файлове, които просто трябва да бъдат затворени с роботи индексиране.

Най-важната характеристика Robots TXT за WordPress е, че той е в основата на вашия блог и да го разписани всички опции за търсачки, които показват, че искате да се индексират на блог и кое не е.

Сега създаване на файла, да го регистрирате и да настроите опциите, които искате в нашия блог. Създаване на robots.txt за WordPress по два начина:

Приставката се нарича «KB Robots.txt». Тя е много проста, и от настройките на страницата има само един прозорец от формата, в която и необходимостта да се направят всички необходими параметри (виж по-долу), след това натиснете бутона «Подайте» да спаси.

Ето моята версия на файла robots.txt в моя блог:

Проблеми с индексиране на вашия блог

В този случай, ако сайта не е необходимо плъгин за показване на връзки с ЦПУ. може да има проблем, когато индексиране страници.

Линия в файла robots.txt:

просто да забрани индексирането на страниците от този тип. Следователно, за да се избегнат проблеми, предлагам ви да отидете на линка по-горе и да персонализирате връзките с ЦПУ в своя блог.

Както можете да видите, че не се използва робот забрана забрани Google :? / * * В robots.txt, а вие не съветвам. Само Yandex!

По този начин, тези дублиращи се страници, ще имат безброй в SERPs като Google. Това ще доведе до разрешаването на които търсачката.

След това ще бъде твърде късно да се оплакват от факта, че вашият блог не може да се изкачи до челните позиции, както и, че трафикът е паднала няколко пъти.

За да направите това, проверете в главната папка на FTP и след това отворете вашия блог, за да редактирате файла .htaccess. След това се монтира в тези думи там:

Това е всичко. Сега, ако роботът ще се премести в дублиран страница, тя веднага пренасочва към главната страница.

Правилни роботи TXT

Между другото, тази версия на файла robots.txt не е истина от последна инстанция. Но това е правилното robots.txt .I мисля така.

Това се дължи на факта, че има много мнения за коректността и бързината на писане или не, на някои директиви във файла.

Еднозначен отговор на този въпрос може да бъде само PS програмисти.

Тук са най-важният резултат и резултатът в момента е както следва:

- Най-панел на Google и Yandex уебмастър няма грешки и коментари за файла robots.txt

Бих искала да отбележа, че работата ми подаде правилно. Проверих това много пъти, което извършва одити блог с различни услуги.

И сега още един трик от мен. Ако имате блог все още млад, но това не е необходимо, но със сигурност полезно в бъдеще.

Да се отървем от натоварването на сървъра

Говоря за увеличеното натоварване на сървъра, при сканиране на робота си блог търсене. За да се отървете от него, трябва да се регистрирате в robots.txt закъснение директива файл обхождане.

Направете го достатъчно лесно. Предписват стойност Crawl-забавяне: 10 след ценности Забрана, Позволи.

Актуализирани роботи TXT за WordPress.

Приятели и сега много важна информация! Ако се вгледате в моите роботи TXT файл, ще видите, че тя не е подобна на тази, която аз Ви предлагам да се инсталира на вашия блог по-рано в тази статия. И всичко това, защото той, за съжаление, не работи.

Да, да, ти чу право. Тя не работи! Фактът, че той всъщност не забранява индексирането на теми като маркер, на страницата, храната, прикачения файл, коментар-страницата, Trackback и категория. Това води до появата на дублиращи се страници, тоест, да дублира съдържание. И се удвоява на страниците, от своя страна, може да доведе до филтрите на търсачките.

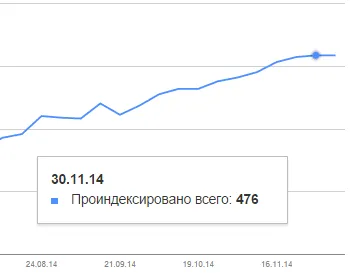

Тази "стадо", отбеляза уважаван блогър Александър Борисов и разказа за това в статия в блога си isif-life.ru. Това беше шок за много блогъри. В резултатите от няколко десетки хиляди страници с двойки. Моят блог също падна под разпределението. Погледнете колко имам страници в индекса на Google:

И въпреки факта, че съм написал 98 статии! 476-98 = 378 страници-необходимо. Пфу ... Имах късмет ...

Но ситуацията в блога си промени графика вече е стабилизирана и скоро тези дублиращи се страници, ще бъдат по-малко и по-малко! Благодарение на Александър за помощта!

Следователно, трябва да прочетете статията на Александра Борисова isif-life.ru блог за това как да се премахне дубликати на тези страници. Но аз смея да кажа, че не цялата информация, предоставена в статията.

Между другото, препоръчвам ви да прочетете статията за mikrorazmetke. Това е много важна тема и голяма помощ за насърчаване на вашия блог!

Желая ти късмет и успех уважение,

Други изделия от интерес:

Книгата е за печалба в интернет:

Сергей, имам още няколко въпроса, но не съм сигурен каква статия е по-добре да попитам, следователно, аз вярвам, че ще има по-подходящи.

Виж, за такъв индекс страница се появи в Google (посочен по-долу). Имате въпроси:

1 Нуждаем ли се от тези страници в индекса?

2 Ако "не", както от близки otindeksatsii в robots.tht или нещо друго?

Базил, първият ми въпрос към вас: "Вие сте конфигурирали на връзките с ЦПУ в блога си?"

Да, CNC е конфигурирана, както следва:

Настройки - Общи настройки - Пермалинковете - Random - /% категория% /% postname% /